SEO mítoszok az elmúlt évtizedből

Immár 10 éve, hogy a piacon tevékenykedünk, jómagam 9 éve vagyok a SEO101 csapatának tagja. Ez összességében – történelmi jelentőségét tekintve – nem egy hosszú időszak, ám, ha figyelembe vesszük, hogy milyen tempóban változik a webes világ, akkor egy 10 éves időszaknak már sokkal nagyobb jelentősége van.

Ha hisszük, ha nem a keresőoptimalizálás az egyik fontos része a sikeres online üzleti életnek, sőt hatással van privát életünkre is, tekintve, hogy kereséseink során leginkább azokkal a weboldalakkal találkozunk elsősorban, amelyeket sikeresen optimalizáltak.

Megpróbáltam összeszedni azokat a keresőoptimalizálás tévhiteket, mítoszokat, amelyek mai napig élnek és virulnak a weben, akár nemzetközi, akár hazai szinten.

A Google = Big Brother?

A Google az egyik (ha nem a) legnagyobb keresőmotor jelenleg a világon, és ugyanígy a világ szinte minden pontján, hogy forgalmat tereljenek weboldalukra a megfelelő célközönségből. A Google a célpontja a keresőoptimalizálás kampányoknak, emiatt a SEO mítoszok nagy része is körülötte forog.

Sokan úgy gondolnak a Google-re, mint a Nagytesóra (Big Brother), amely figyeli tevékenységünket, és ha rosszat csinálunk, akkor kezünkre csap. Ez bizonyos értelemben igaz is, azonban jó hír, hogy a Google önmagában nem egy rejtélyes entitás. Maga a Google rengeteg irományt tett közzé, mely segít megérteni működését, és az irányelvek betartását egyszerűbbé teszi.

Emellett sok könyv foglalkozik a Google korai életével is, ilyen például az „In the Plex”, melyet Steven Levy írt és 2011-ben jelent meg. Az ilyen típusú könyvek azért hasznosak, mert rávilágítanak, hogy a Google mögött is emberek állnak, akik próbálnak valami hasznosat létrehozni a felhasználók számára. Az természetesen más kérdés, hogy mindez mennyire valósul meg a végén.

A Google-t megérteni természetesen nem egyszerű azok számára, akik még csak most ismerkednek a lehetőségeivel, tekintve az utóbbi évek felgyorsult tempóját, amit a kereső diktál.

A Google számos SEO kampány és üzletág alapvető építőköve, épp ezért természetes, hogy szeretne kommunikálni a weboldal tulajdonosokkal és cégvezetőkkel is. A webmester útmutatók oldalán, a support oldalakon, a fejlesztői oldalakon vagy a kutatási publikációk oldalain rengeteg hasznos dolgot tudhatunk meg közvetlenül a fejlesztőktől.

Minden információt itt érdemes először ellenőrizni, mielőtt elhinnénk, és az optimálissal merőben ellentétes tevékenységre ragadtatnánk magunkat, ugyanakkor azt is érdemes szem előtt tartani, hogy olykor a Google hivatalos kommunikációját is érdemes fenntartásokkal kezelni.

Latent Semantic Indexing, avagy ősrégi indexelés?

Nézzük meg, hogy néhány ősrégi technológia hogyan képes SEO mítoszokat kelteni a modern keresőoptimalizálásban. A késői 1980-as években, mielőtt még létezett a World Wide Web, a Bell Labs kutatói közzétettek egy tanulmányt, amelyben egy ideális indexelési eljárást írtak le egy fix adathalmazhoz. A szabadalom gyakorlatilag kiadott egy adatot egy adathalmazból, viszont minden alkalommal, amikor új adat került az adott adathalmazba, az indexelést újra el kellett végezni.

A web természetesen sokkal nagyobb információs halmazzal rendelkezik, mely folyamatosan változik, adatok kerülnek be és tűnnek el rendszeresen. Az LSI egy olyan technológia volt, mely a web előtt készült és nem arra volt kitalálva, hogy a web igényeit kielégítően tudjon adatokat indexelni. Az LSI-re azóta hivatkozik a Google is néhány szabadalomban, de csak említés szinten, ez viszont elegendő alapot adott a mítoszok terjedésének.

Hogy mi a valóság ma?

A Google ma már olyan természetes nyelvi alapú előfeldolgozási eljárásokat használ, mint a BERT algoritmus, amely 2019 október vége óta magyar nyelvterületen is fut, és a keresések 1-10%-át érinti. Lényege, hogy „emberszerűbben” próbálja megérteni a nyelvet, vagyis az olyan nyelvi „finomságokat” is megérti, ami a fogalmi összefüggésekben teljesedik ki.

A BERT, valamint a RankBrain algoritmus – amiről kicsit később esik szó – olyan új eljárások, amellyel kielégíthető a web nagy adathalmazainak pontos és gyors indexelése, ez pedig az LSI-vel, és a régi technológiákkal nem volt lehetséges.

Mit kell tudni az LSI kulcsszavakról?

Az LSI kulcsszavakról mi is írtunk, ám sokan hibásan hivatkoznak rá, és néhány SEO mítosz forrásává is vált az elmúlt években. Nézzünk rá tehát ezekre:

Az LSI kulcsszó nem egyenlő az LSI szabvánnyal. Az LSI ebben a tekintetben csupán azt jelenti, hogy olyan kapcsolódó szavakat társítunk egy megadott kulcsszóhoz, amelyeket el lehet helyezni a forrásoldalon.

Látjuk tehát, hogy egy kulcsszókutató eszközről van szó, aminek a lényege, hogy szemantikai kapcsolatban lévő szavakat ad egy oldalhoz, sokan az LSI kulcsszavakat úgy is értelmezték, mint lekérdezéseket, amelyek az organikus találati lista alján jelennek meg, azonban ez sem teljesen igaz.

Valójában az egészben a lényeg, hogy az oldalakon olyan kulcsszavak legyenek, melyek relevánsak, és így az emberek minél előbb megtalálják ezekkel a kulcsszavakkal azokat az oldalakat, amelyekre épp szükségük van.

A Hummingbird (Kolibri) frissítéssel 2013-ban a Google igazolta is ezt a szándékát. Az algoritmus a szemantikus keresés korszakát nyitotta meg, amellyel az emberek keresési szándékát igyekszik megérteni, vagyis azokat az oldalak részesíti előnyben az organikus listán keresési eredményként, amelyek az emberek szituációs és informális igényeit legjobban kielégíti.

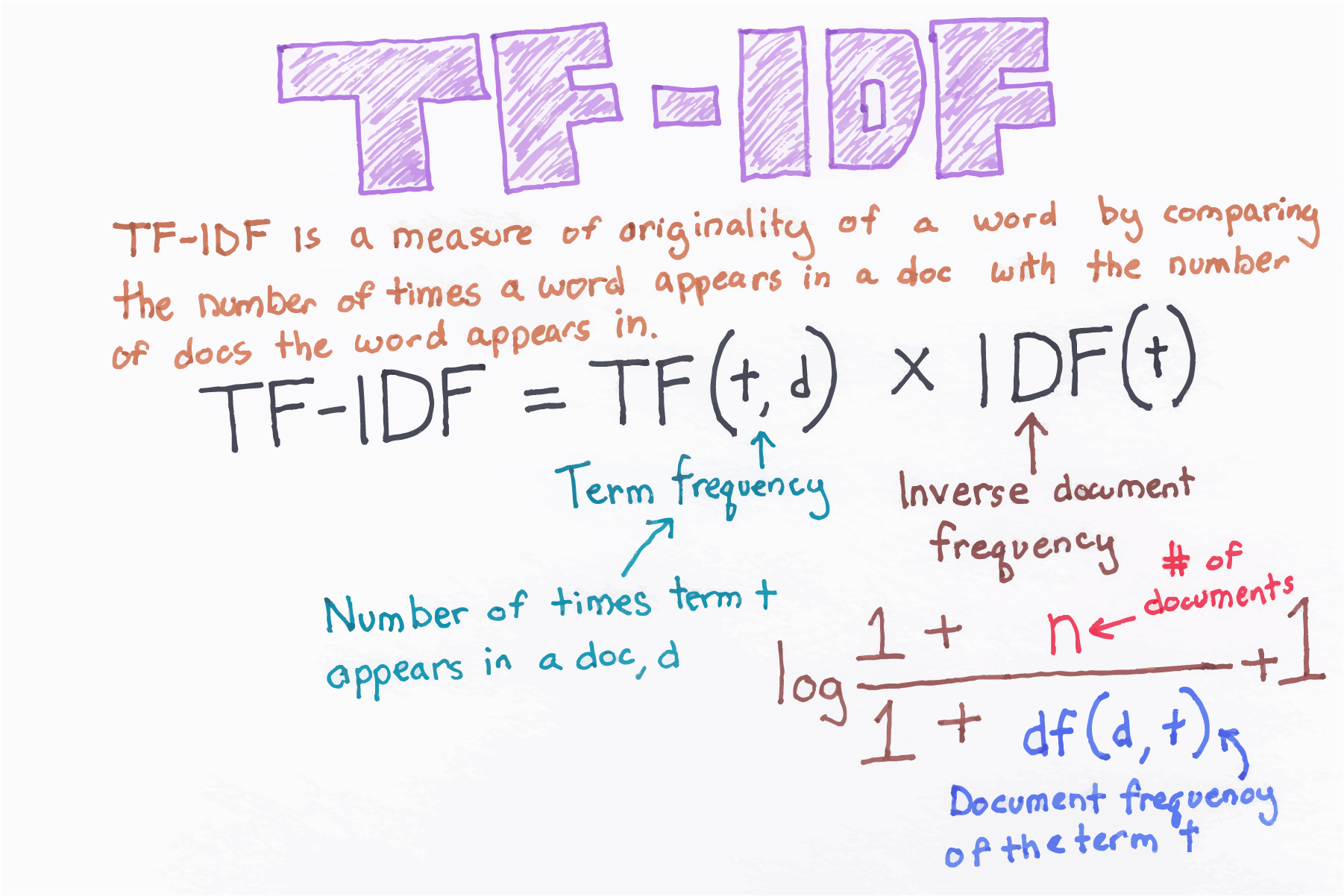

TF-IDF szerepe

Sokan keresőoptimalizálási csodaszerként tekintenek rá, amivel tökéletesre lehet optimalizálni egy weboldal szöveges tartalmát. Valójában mindez csak nyomokban tartalmaz igazságot.

Az LSI-hez hasonlóan a TF-IDF is valójában egy régi indexelési metódus, mely szintén a World Wide Web ideje előtt látott napvilágot. Ez a szabvány egy kifejezés gyakoriságát vizsgálja egy dokumentumban, továbbá azt is, hogy az adott kifejezés egy nagyobb, már indexelt dokumentum adatbázisban milyen gyakorisággal fordul elő. Ebből könnyen kiderül, hogy egy adott oldal egy specifikus kifejezés köré épül-e, továbbá az is, hogy egy adatbázisban mennyire gyakori ez az adott kifejezés.

A TF-IDF saját idejében jól hangzott, azonban az első keresőmotorokban lecserélték egy fejlettebb verzióra, a BM25-re. A TF-IDF azonban máig is kelt egy kis félreértést, ugyanis sokan utalnak rá egy folyamat részeként, mely felismeri a lekérdezés hatékonyságát növelő paramétereket, ezek pedig a keresési lista alján kerülnek feltűntetésre a Google-ban. Valójában sosem utalt rá senki úgy, mint szerves részeként annak a folyamatnak, hogy a weboldalak miként indexelődnek a valóságban.

Számos eszköz létezik, mely segít tartalmakat létrehozni, úgy, hogy lefuttatnak rajtuk egy TF-IDF folyamatot, összehasonlítva azokkal az oldalakkal, melyek jó helyezéseket érnek el a kiválasztott kifejezésekre. Mindennek az a célja, hogy a gyűjtött adatokkal létrehozhassunk olyan tartalmakat, amelyek hasonlóan jól szerepelnek, mint a TF-IDF-el elemzett weboldalak.

Az ilyen eszközök használata érdekes. Ha például azt akarjuk, hogy egy weboldal egy adott kifejezésre jól szerepeljen a találati listán, akkor ezek a módszerek működhetnek. Tegyük fel, hogy egy oldalt arra a kifejezésre akarunk keresőoptimalizálni, hogy „Mi a SEO alapja?” A probléma viszont az, hogy az egyes szavak nem kapcsolódnak szorosan szemantikailag, hiszen az „alap” és a „SEO” kapcsolatát nem sok minden indokolja. Ebben az esetben tehát elérhetjük, hogy egy oldal jól válaszoljon erre a kifejezésre, de más hasonló kulcsszavak és kifejezések esetében nem biztos, hogy lesz fejlődés, tehát a TF-IDF sem igazi csodaeszköz, de egész sok keresőoptimalizáláshoz kapcsolható tévhit lengi körül.

Trustrank, MozRank, van közük a Google-höz?

Sokan összekapcsolták a Trustrank és MozRank szerepét a Google-el, mint a Google azon algoritmusát, mely megbízhatóság szerint rangsorolja a weboldalakat. Ez azonban így valóban csak egy SEO mítosz.

A Trustrank lényege, hogy rosszindulatú, spam-es, adathalász weboldalakat felismerjen a web-en és korlátozza azok hatékonyságát. Az ilyen oldalak ugyanis számos módszert használnak, hogy indokolatlanul jó helyezést érjenek el a találati listákon, ezzel pedig egyre több és több keresőhöz jutnak el.

A szakértők természetesen ki tudják szűrni ezeket az oldalakat, azonban túl sok van belőlük, hogy mindet manuálisan szemügyre vegyék. A Trustrankkal néhány úgynevezett „magoldalt” alapul vesznek a kutatók, amelyek megbízhatók, majd a web linkstruktúrájának köszönhetően felfedezik azokat az oldalakat, melyek ezekhez kapcsolódnak és szintén megbízhatók.

Habár a Trustrank szorosan kapcsolódik a keresőmotorokhoz, a Google-höz közvetlenül semmi köze nincs, ez pedig keresőoptimalizálás szempontból fontos. A Trustrank a Yahoo kreációja, és bár a Google-t érdekelte a fejlesztés, hivatalosan nem implementálták semmilyen részét. A Trustrank nem rangsorol weboldalakat, csupán felfedezi azokat, melyekkel probléma van, és jelzi azokat a Yahoo-nak.

A Google ezzel szemben az egyéni kereséseket veszi alapul és megjelöli azokat a weboldalakat, melyek egy adott témában, kontextusban megbízhatónak és sikeresnek bizonyultak. Ezeket fogja később alapul venni, ezeket veszi sztenderdnek és „szakértőnek”, ezekhez hasonlítja a többi weboldalt.

Hasonlóan a Moz is egy a Google-tól teljesen független marketing vállalkozás, akik olyan SEO eszközöket fejlesztettek, amelyek a weboldalak értékének számszerű megadására törekszik bizonyos módszerek segítségével (pl. az adott domainre mutató linkek minőségének elemzésével).

Az általuk fejlesztett speciális mérőrendszer értékeit (Domain Authority, Page Authority, Spam Score) jelenleg a magyar piacon is használjuk adott domain erősségének megállapításához. Ez viszont nem egyenlő azzal, amit a Google „gondol” egy adott weboldalról, bár a tapasztalatok szerint a Moz értékei és az adott oldal helyezése korrelál egymással.

A RankBrain körüli mítosz

A Google történelmében egy hosszú fejezetet tesz ki a keresési algoritmusok fejlődésének története.

Az egyik legismertebb egy 2003-as szabadalom volt, amelyben szemantikai bővítésről beszéltek, tehát belevették a találatokba azokat a kifejezéseket is, melyek szinonímái vagy közeli rokon értelmű szavai voltak az eredeti keresett kifejezésnek.

2013-ban a Hummingbird frissítéssel olyan mértékben is módosulhatott már egy lekérdezés, mint a következő példa, vegyük azt a keresést, hogy: “Mely az a hely, ahol jó olasz kaja kapható?” A Hummingbird frissítés után ebből végül az lehet, hogy Mely az az „étterem”, ahol jó olasz kaja kapható?

A változást a RankBrain-nek köszönhetjük, egy speciális word vector, avagy szóalapú vektor technológián alapul, melyet a Google Brain csapat fejlesztett ki. A lényege az, hogy az algoritmus tökéletesíti a kereséseket a felhasználó korábbi keresései és tendenciái alapján, továbbá általános emberi preferenciák alapján.

Tegyük fel, hogy valaki rá akar keresni valamire, de nem a legjobb kulcsszavakat írja be. A RankBrain a keresést átírhatja úgy, hogy az olyan legyen, amit a felhasználó elképzelt, csak nem megfelelően, vagy nem eléggé pontosan adta meg. A RankBrain célja főleg a kétértelműség lecsökkentése volt a keresésekben, ez viszont felvet egy érdekes kérdést SEO szempontból.

Lehet a RankBrain-re optimalizálni?

A Google álláspontja szerint nem. Mivel maga a RankBrain is részben mesterséges intelligencia és tanulás alapján dolgozik, ezért logikusan hasonló technológiákat kéne alkalmazni az optimalizálásnál is.

Általános tanácsok között ott szerepel a megfelelő tartalom, mely növelheti az emberek által az oldalon eltöltött időt, ezek azonban alapvetően más irányelveket szolgálnak.

A legtöbb sikeres SEO stratégia a már jól ismert irányelvek kiszolgálása felé történik, és nem feltétlen a RankBrain kielégítésére. Erre jelenleg nincs lehetőség, és az igazság az, hogy akár a magyar, akár más nyelvterületekről nem érkezett számottevő visszajelzés az algoritmus hatásairól, így további mítoszt nem érdemes köré építeni.

A linkek nem számítanak

Ezt tovább fokozhatnánk azzal a mítosszal, hogy „a linkeket bünteti a Google”, vagy a linképítés = black hat SEO, vagy a „linképítésre azért nincs szükség, mert jó tartalmat írok”.

Ezekkel, és ehhez hasonló mítoszokkal még 2019-ben is többször találkoztunk, és terjedésükben nagy felelősségük van az önjelölt SEO szakembereknek is, akik félinformációkból adják el magukat.

Igen, a linkek számítanak, és szükség van rájuk a keresőoptimalizálás során. Amíg a weboldalak egymás között csak hiperhivatkozással tudnak kapcsolatot teremteni, addig mindig is számítani fog, és mivel a linkek értelmezésében óriási változás állt be, így a jó minőségű, valós linkek egyre drágábbak is lesznek.

SEO = on site SEO vs. SEO = linképítés

A weboldal tulajdonosok döntő többsége nem tud különbséget tenni az offsite és az on site SEO között. Gyakran találkozunk azzal a mítosszal, hogy a „webesem már beállította a SEO-t az oldalon”, vagy „ha veszek egy fix mennyiségű linket, akkor kész a SEO”, esetleg „mennyi idő alatt kerülök a TOP3-2-1 pozícióba?”, vagy „nyomjunk bele minél többet, mert akkor hamarabb előre kerül az oldalam, a lehető legnagyobb kereséssel és versennyel rendelkező, általános kulcsszóra”.

Mindezek a kérdések csak azért merülhetnek fel, mert valószínűleg hasonló jellegű mítoszokkal találkoznak a weboldal tulajdonosok a weben, vagy ehhez hasonló tanácsokat kapnak.

A valóság az, amire a ma embere olykor képtelen, hogy összefüggéseiben kell nézni és értelmezni a dolgokat. A SEO ilyen szempontból már nem fekete és fehér, nem csak az on site, az off site, vagy a linképítés, sőt! a szövegírás, a tartalommarketing tengelyén épül fel, hanem ezek összessége, és még ezen túlmenően is, sok esetben a szakértelmen túl a klasszikus „józan paraszti ész” is szükséges.

Amennyiben pedig elhisszük, hogy a Google is próbál ember módjára gondolkodni öntanuló algoritmusaival, akkor 2020-ban igenis szükség lesz a józan paraszti ész „termelte” logikára.

Ha weboldaladnak pedig mítoszoktól és tévhitektől mentes teljes körű keresőoptimalizálásra lenne szüksége, pénz visszafizetési garanciával, akkor keress meg minket!

Ha úgy érzed megkeresnél minket:

Inkább írok!